# 오늘 코드 - 조은 강사님과 함께하는 수업💖

# 12주차 동안 진행한 3일의 수업 중 더 공부해보고싶거나 복습해보고 싶었던 내용 정리입니다.

CNN 모델

- 전이학습(Transfer Learning)이란?

- 사전적 정의

한 분야의 문제를 해결하기 위해서 얻은 지식과 정보를 다른 문제를 푸는데 사용하는 방식 - CNN에서의 전이학습

'이미지 분류' 문제를 해결하는데 사용했던 네트워크를 다른 데이터셋 혹은 다른 문제에 적용시켜 푸는 것

💡 다양한 이미지의 보편적인 특징 혹은 피처(Feature)들을 학습했기 때문에 전이학습을 수행하지 않은

모델들보다 비교적 빠르고 정확한 정확도를 달성할 수 있음 !

😊 아래에서 전이학습에 사용될 수 있는 유명 CNN 모델에 대해 알아보자 !

- 사전적 정의

◆ LeNet

- CNN을 처음으로 개발한 얀 르쿤 연구팀이 1998년에 개발한 CNN 알고리즘

- 구조

✔ 3개의 컨볼루션 레이어, 2개의 서브샘플링 레이어, 1개의 full-connected 레이어로 구성

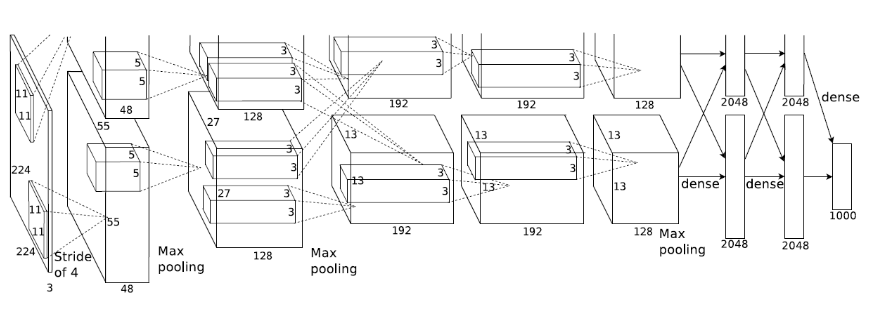

◆ AlexNet

- 인공지능의 classification 대회인 ILSVRC에서 2012년 당시 오차율 16.4%로 우승한 모델

- LeNet-5와 차이 : 2개의 GPU로 병렬연산을 수행하기 위해서 병렬적인 구조로 설계

- 구조

✔ 5개의 컨볼루션 레이어와 3개의 full-connected 레이어로 구성

◆ VGGNet

- 2014년 이미지넷 이미지 인식대회에서 준우승을 한 모델

- 옥스포드 대학 연구팀 VGG에 의해 개발된 모델

- 사용하기 쉬운 구조와 좋은 성능 덕분에 그 대회에서 우승을 거둔 더 복잡한 형태의 GoogleNet보다 더 인기를 얻음

◆ ResNet

- 마이크로소프트에서 개발한 알고리즘

- Residual Learning이라는 개념을 통해 모델의 층이 깊어져도 학습이 잘 되도록 구현한 모델

- 구조

✔ VGG19의 구조를 기본으로 Convolution 층과 shortcut들을 추가한 구조

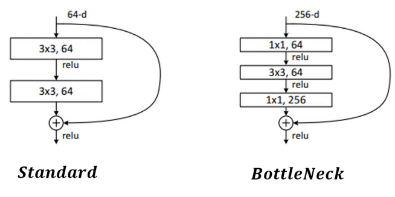

✔ Shortcut과 Bottleneck 구조 - 핵심 개념

- Shortcut

: H(x) - x = F(x) 로 두어 F(x)를 최소화 (Residual block 방식 사용)- x : 입력값

- F(x) : CNN Layer -> ReLU -> CNN Layer 을 통과한 출력값

- H(x) : CNN Layer -> ReLU -> CNN Layer -> ReLU 를 통과한 출력

📌 F(x) = 0이라는 목표값이 주어지기 때문에 학습이 더 쉬워짐

📌 네트워크를 깊게 쌓아도, Main path에서 Optimal depth이후의 Weight와 Bias가 전부 0에 수렴하도록

학습된다면 Optimal depth에서의 Output이 바로 Classification으로 넘어갈 수 있음

📌 미분을 했을 때 더해진 x가 1이 되어 기울기 소실 문제가 해결

- bottleneck

기존의 Standard 는 한 블록에 Convolution Layer(3X3) 2개가 있는 구조를

Convolution Layer(3X3) 1개와 앞 뒤로 Convolution Layer(1X1) 2개를 사용하는 bottleneck 구조를

사용하여 파라미터 수를 감소시키면서 신경망의 성능을 유지시킴

- Shortcut

출처

전이학습(Transfer Learning)이란?

dacon.io

Implementing Yann LeCun’s LeNet-5 in PyTorch

Recently, I watched the Data Science Pioneers movie by Dataiku, in which several data scientists talked about their jobs and how they…

towardsdatascience.com

3) ResNet, ResNet의 확장(레이어 152개 이하)

## ResNet  CNN을 연구하면서 기존 모델들…

wikidocs.net

[딥러닝] DeepLearning CNN BottleNeck 원리(Pytorch 구현)

안녕하세요. 오늘은 Deep Learning 분야에서 CNN의 BottleNeck구조에 대해 알아보겠습니다. 대표적으로 ResNet에서 BottleNeck을 사용했습니다. ResNet에서 왼쪽은 BottleNeck 구조를 사용하지 않았고, 오른쪽은 B

coding-yoon.tistory.com

http://yann.lecun.com/exdb/publis/pdf/lecun-01a.pdf

https://papers.nips.cc/paper/2012/file/c399862d3b9d6b76c8436e924a68c45b-Paper.pdf

'2022년 > [멋쟁이 사자처럼] AI 회고' 카테고리의 다른 글

| [10주차] 추가공부 (1) | 2022.11.24 |

|---|---|

| [9주차] 추가공부 (0) | 2022.11.17 |

| [8주차] 추가공부 (0) | 2022.11.10 |

| [7주차] 추가공부 (0) | 2022.11.03 |

| [2주차] 추가 공부 (1) | 2022.09.29 |